Hoe kunnen inwoners zeker weten dat de overheid op een menselijke manier met hen communiceert, als er steeds meer generatieve AI door de overheid wordt gebruikt? De demissionair staatssecretaris Digitalisering hamert op transparantie en menselijke controle.

Hallo, spreek ik met een AI?

Overheidscommunicatie die is gemaakt met behulp van generatieve AI moet als zodanig te herkennen zijn.

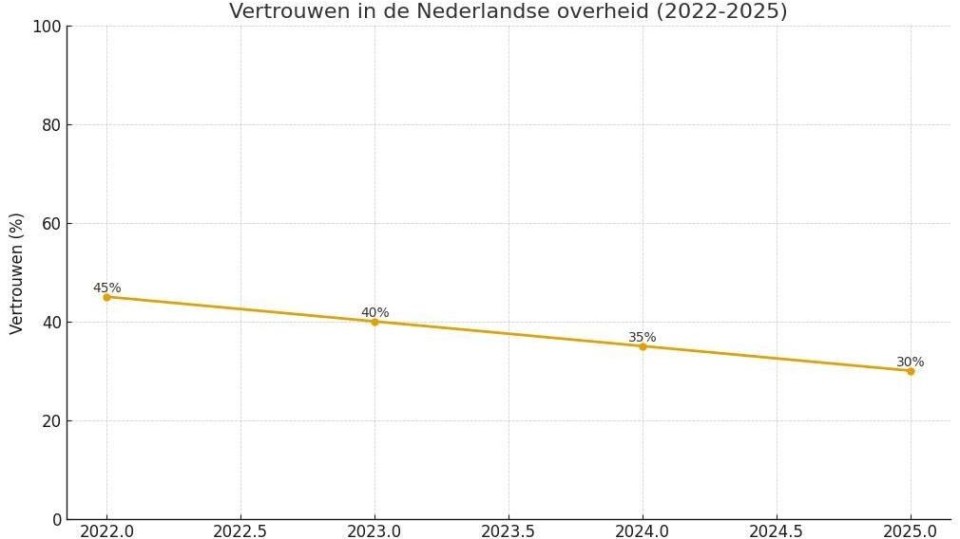

Vertrouwen

De vaste commissie Digitale Zaken maakt zich zorgen over de invloed van generatieve AI in de communicatie van de overheid met inwoners en stelde een aantal vragen over dit onderwerp aan demissionair staatssecretaris Van Marum voor Digitalisering (BBB) naar aanleiding van het Overheidsbreed standpunt generatieve AI. Hoe moeten inwoners weten of een overheidsbericht afkomstig is van een mens of een AI-model? En wat doet het met het vertrouwen in de overheid als de overheid steeds meer generatieve AI inzet?

Als zodanig herkenbaar

In de beantwoording van de vragen wijst Van Marum op de wettelijke verplichtingen rondom generatieve AI. In de Europese AI-verordening staat dat AI-gegenereerde content als zodanig herkenbaar moet zijn. Deze verplichting is in werking getreden op 2 augustus 2025. Ook de Nederlandse handreiking generatieve AI voor de overheid vereist transparantie over genAI-gebruik.

Redactionele controle

Als AI wordt ingezet in overheidscommunicatie, is het verplicht dat een menselijke medewerker zich vervolgens over de gegenereerde content buigt, of het nu een brief, een video of een tabelletje in een appendix is. AI-systemen maken fouten. Overheden en medewerkers moeten zich hier bewust van zijn, schrijft Van Marum. Redactionele controle moet voorkomen dat er onjuistheden in de gegeneerde inhoud blijven staan.

Daarnaast moet bij alle door AI gegenereerde content duidelijk worden gemaakt dat er AI aan het werk is gezet. ‘Als uit de vele pilots en experimenten die momenteel plaatsvinden blijkt dat generatieve AI verantwoord kan worden ingezet voor direct contact met burgers, zal ik onderzoeken op welke wijze duidelijk kan worden gemaakt dat een tekst tot stand is gekomen met behulp van generatieve AI,’ schrijft Van Marum.

Generatieve AI is een hulpmiddel en kan geen verantwoordelijkheden dragen.

Demissionair staatssecretaris Van Marum

Watermerk

Vanaf 2 augustus volgend jaar zijn aanbieders van AI-systemen zelf verplicht om AI-gegenereerde inhoud van een machineleesbaar watermerk of iets dergelijks is voorzien, zodat je altijd kunt achterhalen of iets is gegenereerd of gemanipuleerd. Ook de makers van deepfakes moeten duidelijk maken dat het om kunstmatige gegenereerde content gaat (wees gewaarschuwd, jongetjes van vijftien die op hun zolderkamertje deepnudes in elkaar knutselen).

Ook als een (overheids)organisatie zelf geen aanbieder is van een AI-systeem maar er alleen gebruik van maakt, is het vanaf augustus 2026 verplicht om duidelijk te maken dat de inhoud gegenereerd of gemanipuleerd is, bijvoorbeeld door in een bijschrijft bij een afbeelding te zetten dat het door AI is gemaakt. De transparantieverplichtingen gelden ook voor chatbots. Gebruikers moeten weten dat ze met een AI-systeem praten en niet met een mens.

De overheid blijft altijd zelf eindverantwoordelijk voor alle overheidscommunicatie naar burgers en bedrijven. Van Marum schrijft: ‘Voor zover het gaat om de verantwoordelijkheid voor het resultaat: generatieve AI is een hulpmiddel en kan geen verantwoordelijkheden dragen.’

Plaats als eerste een reactie

U moet ingelogd zijn om een reactie te kunnen plaatsen.