Een akkoord binnen het Europees Parlement over de AI Act leek al binnen handbereik, toen de opstellers ervan werden verrast door de komst van generatieve AI voor consumenten.

Uitstel AI Act dreigt door komst ChatGPT

Met generatieve AI voor het grote publiek had de Europese wetgever geen rekening gehouden bij het schrijven van de AI Act.

Lastig parket

100 miljoen actieve gebruikers telde ChatGPT, al een maand na de release. Het Large Language Model genereert allerlei soorten teksten, van beleidsstuk tot Sinterklaasgedicht, zonder dat de gebruiker over enige programmeerkennis hoeft te beschikken. Ook plaatjesgeneratoren zoals Midjourney en Stable Diffusion zijn relatief laagdrempelig; je hoeft alleen maar te snappen hoe je een prompt schrijft, de opdracht op basis waarvan de AI een beeld genereert. De opkomst van generatieve AI, kunstmatige intelligentie die zelf tekst, afbeeldingen, audio, video of code kan ontwikkelen, lag in de lijn der verwachtingen. Large Language Models, die aan de basis staan van dergelijke AI, bestaan al langer. Maar dat generatieve AI opeens voor het grote publiek beschikbaar is, blijkt een verrassing voor de opstellers van de Europese AI Act. Het stelt ze voor een lastig parket.

Risicocategorieën

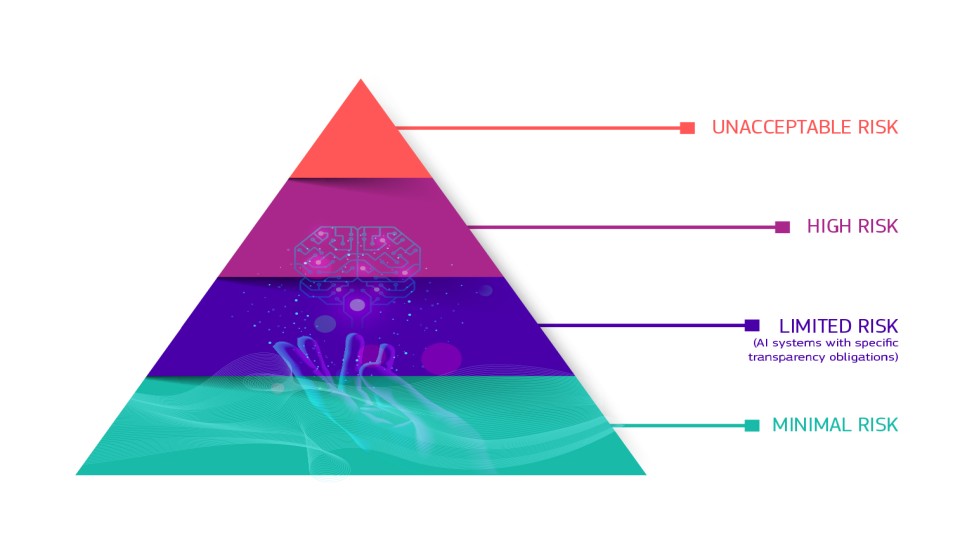

Het Europese wetsvoorstel, voluit ‘Proposal for a Regulation laying down harmonised rules on artificial intelligence’ gaat uit van professioneel gebruik van AI-systemen. Daarbinnen wordt onderscheid gemaakt tussen systemen die een onaanvaardbaar risico vormen voor de samenleving, systemen met een hoog risico, een beperkt risico en een minimaal risico. Hoe hoog het risico is, wordt volgens de logica van de AI Act bepaald door het einddoel dat de producent voor ogen heeft. Ook maakt het uit in welke sector het wordt ingezet; onder meer onderwijs en defensie zijn hoogrisicosectoren. Maar het kenmerk van generatieve AI is nu juist dat het voor allerlei toepassingen te gebruiken is, en dat we dat ook massaal doen.

Overregulering

In welke categorie hoort ChatGPT dan thuis? Onder de hoog-risicobepalingen, stellen de rapporteurs die binnen het Europees Parlement werken aan voorstellen voor de AI-regelgeving. Het gaat om AI-systemen die zonder menselijke tussenkomst complexe teksten voortbrengen. Maar op dat voorstel is kritiek, onder meer van Natali Helberger, universiteitshoogleraar op de leerstoel Law and Digital Technology aan de Universiteit van Amsterdam. Zij voorziet overregulering indien generatieve AI in alle gevallen onder de hoog-risicobepaling terechtkomt. ‘De hoog-risicobepalingen zijn geschreven voor een situatie waar een bedrijf bepaalde AI-systemen als oplossing voor bepaalde problemen bouwt, die vervolgens door professionele gebruikers worden gebruikt, in een organisatorische context waarin waarborgen zijn ingebed,’ zegt ze. ‘Wat nu gebeurt is dat iedereen, van academicus tot politieman, generatieve AI kan gebruiken. En vaak zijn de toepassingen vrij onschuldig, maar ze brengen ook risico’s met zich mee die niet in de hoog-risicobepalingen worden beschreven, zoals het genereren van desinformatie en het schenden van auteursrecht of privacy.’

Eindgebruiker buiten beeld

Niet de aanbieder van generatieve AI, maar de eindgebruiker bepaalt wat ermee wordt gedaan. Maar die eindgebruiker komt in de huidige AI Act nauwelijks voor. Helberger geeft een voorbeeld: ‘In de huidige regelgeving staat dat een systeem transparant moet zijn in de zin dat een gebruiker moet weten of hij met een AI of een mens communiceert. We hebben geen corresponderende bepaling die zegt dat ik er zélf transparant over moet zijn als ik een tekst schrijf met behulp van generatieve AI.’

Aparte categorie

Helberger pleit voor een aparte risicocategorie voor wat in de AI Act general purpose AI heet, ofwel AI voor algemeen gebruik. ‘We moeten goed nadenken wat voor waarborgen we nodig hebben om het veilig te stellen op zo'n massieve schaal. Je wil dat bepaalde waarborgen over datakwaliteit en transparantie al in het systeem zitten, voordat het op de markt wordt gebracht. Daarnaast is een gevoel van verantwoordelijkheid bij de eindgebruikers nodig. Voor hen moet het bijvoorbeeld makkelijk worden gemaakt om misbruik te melden.’

Ze stelt onder meer voor dat er een monitoringsplicht komt voor de aanbieders, vergelijkbaar met de verplichtingen voor vlops (very large platforms) onder de Digital Services Acts. Ook is er meer aandacht nodig voor contractuele oplossingen. ‘In het consumentenrecht kijken we al heel lang of er sprake is van een eerlijke en geschikte verantwoordelijkheidsverdeling in de gebruikersvoorwaarden. Dat moet in de technologiesector veel gebruikelijker worden.’

Doordenderende trein

Of de AI Act daadwerkelijk vertraging oploopt, is niet met zekerheid te zeggen. Helberger heeft de indruk dat ‘de trein gewoon doordendert’ en dat men probeert om men hogere snelheid een oplossing te vinden. ‘Mijn indruk is dat men nog steeds probeert de onderhandelingen over de AI Act binnen het jaar af te ronden, en de hoog-risicobepalingen over generatieve AI in een uitvoeringshandeling vast te leggen. Losse eindjes worden daarin dan later verwerkt.’

Een pragmatische oplossing, vindt ze. ‘Als je wetgeving maakt op een terrein dat zo ongelooflijk dynamisch is, kun je niet wachten op de nieuwste stand van de technologie, want dan komt de wet nooit af.’ Haar enige zorg is hoe democratisch de uitvoeringshandeling tot stand komt. ‘Als maatschappij moeten we kunnen meedenken over hoe onze toekomst met AI eruitziet. Dat moet onderdeel zijn van het wetgevingsproces.’